重点 1

该工具有效地在数据到达 ClickHouse 之前从 Kafka 流中移除重复数据,确保实时分析的数据洁净。

重点 2

通过自动订阅功能,它简化了与 Kafka 连接的过程,节省了消费者管理的时间。

重点 3

原生连接器确保数据高效引入,失败时自动重试,提供强大的数据处理能力。

改进 1

尽管该工具在标准负载下表现良好,但在处理显著更大的数据流时,尤其是在高度动态的环境中,可能会面临挑战。

改进 2

该工具可能受益于更友好的界面或增强的文档,以帮助用户进行设置,尤其是对于非技术用户。

改进 3

尽管自动处理重试,但更好的错误可见性和日志记录可以帮助更快地解决问题,尤其是在生产环境中。

产品功能

可以增加更先进的可扩展性功能,例如增强的分区或负载均衡,以更高效地处理更大数据集。

UI & UX

考虑改善用户界面和用户体验,以便于配置,尤其是对于新用户。基于网页的仪表板可以简化监控和设置过程。

SEO 或营销

通过增加关于用例和案例研究的内容来改善 SEO,以帮助吸引更多用户。此外,针对具体行业(如电子商务、金融)进行宣传将提升可见性。

多语言支持

添加多语言支持以便于文档和用户界面的访问,可以扩展该工具在全球范围的可用性。

- 1

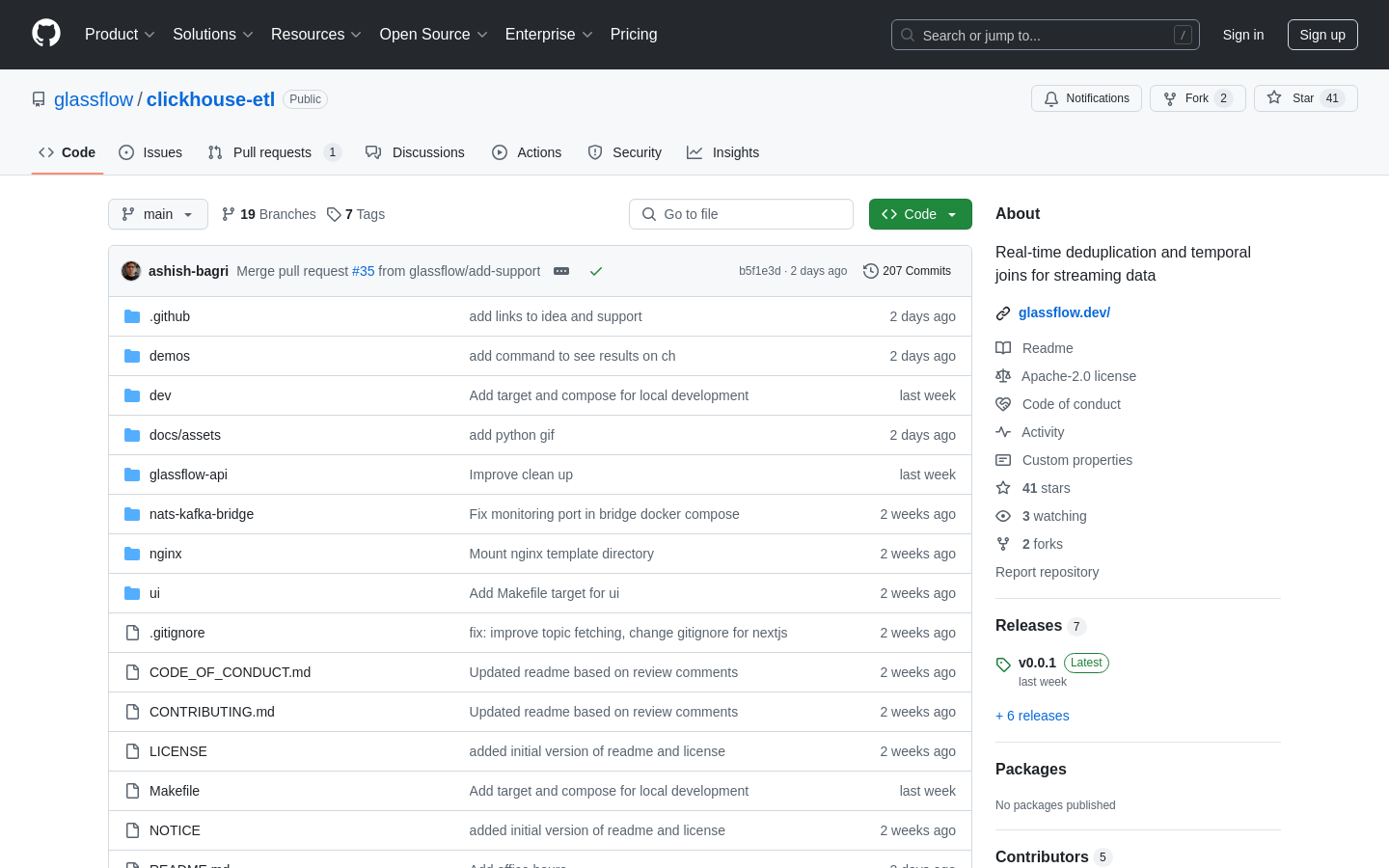

ClickHouse ETL 如何处理 Kafka 流的去重?

ClickHouse ETL 通过根据定义的键和时间窗口(最长可达 7 天)实时检查重复记录,从而去重 Kafka 流。这确保只有唯一记录被引入 ClickHouse,防止重复。

- 2

我可以使用 ClickHouse ETL 连接两个 Kafka 流吗?

可以,ClickHouse ETL 支持时态流连接,允许您根据键和时间窗口连接两个 Kafka 流,简化实时数据分析。

- 3

数据如何被引入 ClickHouse?

该工具使用原生 ClickHouse 连接器引入数据。它通过可配置的批量大小和刷新间隔优化性能,确保高效的数据传输。还包括自动重试,以防止在瞬时故障时数据丢失。